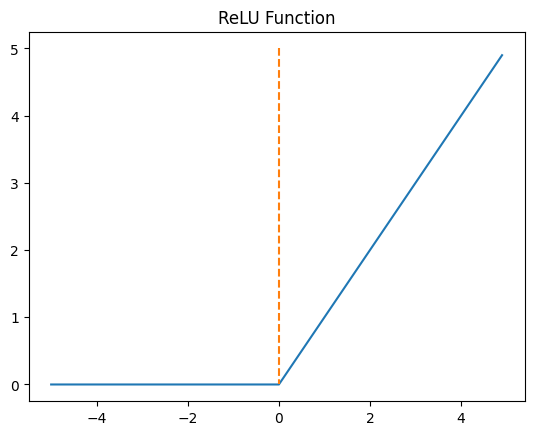

음수를 입력하면 0 을 출력, 양수를 입력하면 입력값을 그대로 반환.

특정 양수값에 수렴하지 않으므로 깊은 신경망에서 시그모이드 함수보다 훨씬 더 잘 작동

연산이 필요하지 않으므로 속도도 빠름

신경망 중간에 시그모이드함수 쓰는것보다는 무지성으로 ReLU 쓰는게 낫다

ReLU 로 선형함수의 출력 (렐루의 입력) 이 음수가 되어, 그 뉴런이 비활성화 된다고 해도 그게 항상 나쁜건 아님

오히려 필요없는 뉴런을 비활성화한다는 개념으로 이해해도 괜찮음.

Dying ReLU

입력값이 음수면 기울기0 >> 뉴런이 죽는다 >> 다시 회생시키기 어려움.

Leaky ReLU : 이 문제를 해결하기 위한 변형함수

원본 링크